دیپ فیک (deepfake) یا جعل عمیق از فناوری هوش مصنوعی برای جایگزینی شباهت یک فرد با فرد دیگر در ویدئو و سایر رسانه های دیجیتال استفاده می کنند. در مورد استفاده از فناوری دیپ فیک برای ایجاد اخبار جعلی و ویدیوهای جعلی و گمراهکننده، نگرانی های وجود دارد. در این مطلب سلام دنیا در مورد اینکه دیپفیک چیست، چگونه کار میکند و چگونه میتوان آن را شناسایی کرد،صحبت خواهیم کرد.

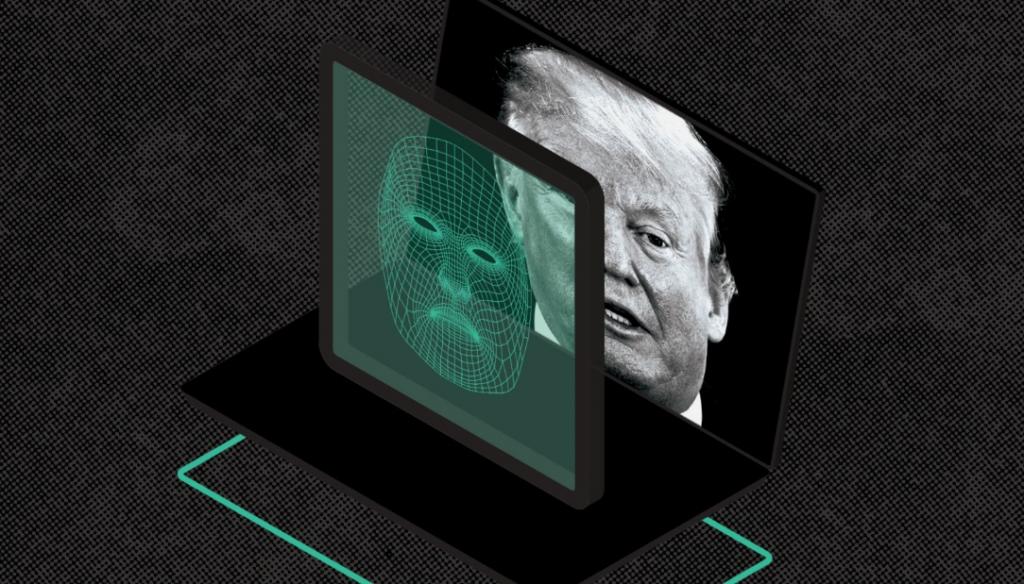

کامپیوترها به سرعت در شبیه سازی واقعیت ها پیشرفت کرده اند. به عنوان مثال، سینمای مدرن بهشدت به جای مکانهای کاربردی و وسایلی که زمانی رایج بودند، به صحنهها، مناظر و شخصیتهای کامپیوتری متکی شده است و اغلب این صحنهها تا حد زیادی از واقعیت قابل تشخیص نیستند. اخیراً فناوری دیپ فیک در سرفصلها خبرها قرار گرفته است.زمانی دیپ فیک آخرین نسخه تصاویر رایانهای را ایجاد می کنند که هوش مصنوعی (AI) برنامهریزی شود تا شباهت یک فرد را با دیگری در ویدیوی ضبطشده جایگزین کند.

دیپ فیک چیست و چگونه کار می کند؟

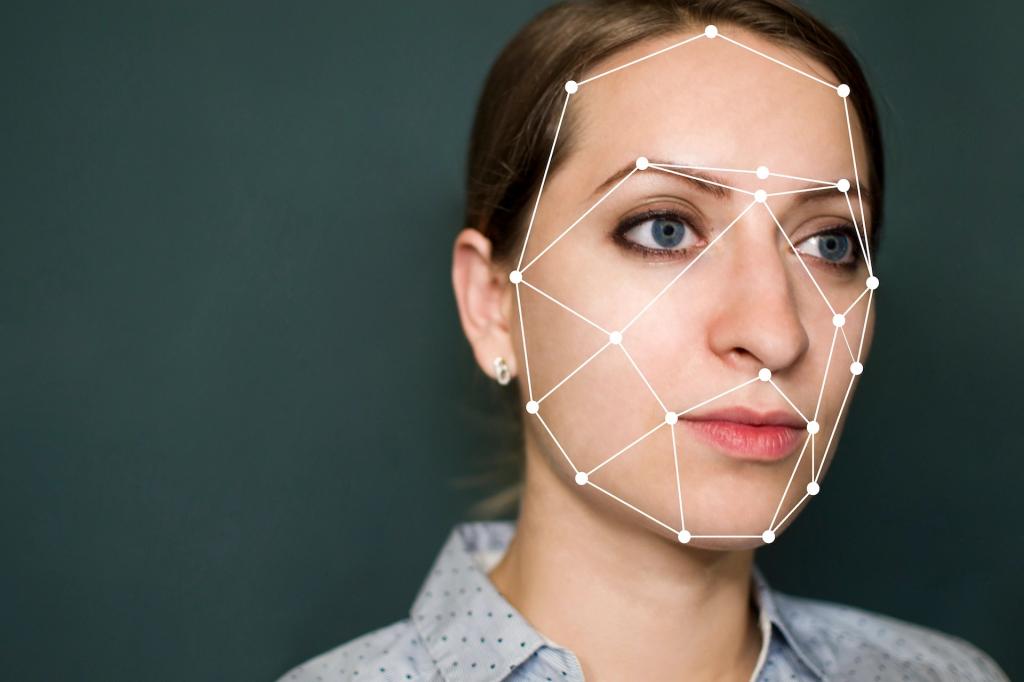

اصطلاح «دیپفیک» از فناوری زیربنایی «یادگیری عمیق» میآید که نوعی هوش مصنوعی است. الگوریتمهای یادگیری عمیق، به آنها یاد میدهد که چگونه مسائل را در صورت داشتن مجموعههای بزرگی از دادهها رفع کنند، در واقع آنها برای مبادله چهره در محتوای ویدیویی و دیجیتالی برای ایجاد رسانههای جعلی با ظاهری واقعی استفاده میشوند. روشهای مختلفی برای ایجاد دیپ فیک وجود دارد، اما رایجترین روشها شبکههای عصبی عمیق که شامل خود رمزگذارها است و از تکنیک تعویض چهره استفاده میکنند. شما ابتدا به یک ویدیوی سوژه نیاز دارید تا از آن به عنوان پایه دیپ فیک استفاده کنید و سپس مجموعه ای از کلیپ های ویدیویی شخصی که می خواهید روی آن قرار دهید.

حتما بخوانید: بهترین شبیه ساز اندروید برای کامپیوتر رایگان

ویدیوها می توانند کاملاً نامرتبط باشند. به عنوان مثال، ویدیوی سوژه ممکن است یک کلیپ از یک فیلم هالیوود باشد، و ویدیوهای شخصی که می خواهید در فیلم درج کنید ممکن است کلیپ های تصادفی دانلود شده از یوتیوب باشند. خودرمزگذار یک برنامه هوش مصنوعی یادگیری عمیق است که وظیفه دارد کلیپ های ویدیویی را مطالعه کند تا بفهمد شخص از زوایای مختلف و شرایط محیطی چگونه به نظر می رسد و سپس با یافتن ویژگی های مشترک، آن شخص را بر روی فرد در ویدیوی مورد نظر کپی کند.

نوع دیگری از یادگیری ماشینی به این ترکیب اضافه میشود که به نام شبکههای مولد تخاصمی Generative Adversaridf al Network یا GANs شناخته میشود، که هر گونه نقص در دیپ فیک را در چندین دور شناسایی و بهبود میبخشد و رمزگشایی آنها را برای آشکارسازهای دیپفیک دشوارتر میکند. GAN ها همچنین به عنوان یک روش محبوب برای ایجاد دیپ فیک، با تکیه بر مطالعه مقادیر زیادی از داده ها برای "یادگیری" نحوه ایجاد نمونه های جدید که شبیه چیزهای واقعی هستند، با نتایج دقیق استفاده می شود.

چندین برنامه و نرم افزار تولید دیپ فیک، کار با این فناوری را حتی برای مبتدیان آسان می کنند، مانند برنامه چینی Zao، DeepFace Lab، FaceApp (که یک برنامه ویرایش عکس با تکنیک های هوش مصنوعی داخلی است)، Face Swap، و DeepNude که از آن زمان حذف شده است، برنامه ای که تصاویر برهنه جعلی از زنان تولید می کرد. تعداد زیادی از نرم افزارهای دیپ فیک را می توان در GitHub، یک منبع جامع توسعه نرم افزار پیدا کرد. برخی از این برنامهها صرفا برای مقاصد سرگرمی استفاده میشوند، به همین دلیل است که ایجاد دیپ فیک غیرقانونی نیست، در حالی که سایر برنامه ها به احتمال زیاد به طور مخرب استفاده میشوند. بسیاری از کارشناسان بر این باورند که در آینده، با توسعه بیشتر فناوری، دیپ فیکها بسیار پیچیدهتر خواهند شد و ممکن است تهدیدهای جدیتری را برای مردم ایجاد کنند که مربوط به دخالت در انتخابات، تنشهای سیاسی و فعالیتهای مجرمانه بیشتر است.

حتما بخوانید: روش تشخیص سایتها و فروشگاه های اینترنتی جعلی

نحوه استفاده از دیپ فیک

در حالی که توانایی تعویض خودکار چهره ها برای ایجاد ویدیوهای فیک معتبر و واقعی، کاربردهای جالبی دارد (مانند سینما و بازی)، اما واضح است که این فناوری با برخی برنامه های دردسرسازش خطرناک است. در حقیقت یکی از اولین برنامه های کاربردی دنیای واقعی برای دیپ فیک، ایجاد فیلمهای مستهجن غیرواقعی بود. در سال 2017، یکی از کاربران Reddit به نام "deepfakes" انجمنی برای فیلمهای مستهجن ایجاد کرد که در آن چهره بازیگران سرشناس به جای چهره افراد در فیلم گذاشته شده بود. از آن زمان،فیلمهای مستهجن(به ویژه فیلمهای مستهجن انتقام جویانه) بارها خبرساز شد و به شدت به شهرت افراد مشهور و چهرههای برجسته لطمه وارد کرد. طبق گزارش، 96درصد از ویدیوهای دیپفیک را فیلم های مستهجن تشکیل میدهد که از سال 2019 به صورت آنلاین یافت میشوند.

ویدیوی دیپ فیک در سیاست نیز مورد استفاده قرار گرفته است. برای مثال، در سال 2018، یک حزب سیاسی بلژیکی ویدئویی از سخنرانی دونالد ترامپ منتشر کرد و از بلژیک خواست تا از توافقنامه آب و هوایی پاریس خارج شود. با این حال، ترامپ هرگز آن سخنرانی را انجام نداد، این یک دروغ ساختگی بود. این اولین استفاده از دیپفیک برای ایجاد ویدیوهای گمراهکننده نبود، و کارشناسان سیاسی متبحر در حوزه فناوری در حال آمادهسازی موجی از اخبار جعلی در آینده هستند که حاوی دیپفیکهای واقعی متقاعدکنندهای هستند. البته، همه ویدیوهای دیپ فیک تهدیدی برای دموکراسی نیستند. دیپ فیک برای طنز نیز مورد استفاده قرار گرفته است، مانند تراشه هایی که به سوالاتی مانند این که اگر نیکلاس کیج در «مهاجمان کشتی گمشده» ظاهر می شد چگونه به نظر می رسید؟

آیا دیپ فیک فقط ویدیو است؟

دیپ فیک فقط به ویدیوها محدود نمی شود. فایل های صوتی دیپ فیک به سرعت در حال رشد است که تعداد زیادی برنامه کاربردی دارد. حالا افرادی که صدای جعلی در دیپ فیک می سازند میتوانند با استفاده از الگوریتمهای یادگیری عمیق طی چند ساعت (یا در برخی موارد، دقیقه) صدای شخصی را سبیه سازی کنند و زمانی که مدل صحبت کردن را ایجاد کردند می توانند به جای ان فرد هر چیزی را بگویند، مانند زمانی که از صدای جعلی یک مدیر عامل برای ارتکاب کلاهبرداری در سال گذشته استفاده شد.فایل صوتی در دیپ فیک دارای کاربردهای پزشکی در قالب جایگزینی صدا و همچنین در طراحی بازی های رایانه ای هم است، در حال حاضر برنامه نویسان می توانند به کاراکترهای درون بازی اجازه دهند به جای تکیه بر مجموعه محدودی از اسکریپت هایی که قبل از شروع بازی ضبط شده اند، هر چیزی را در زمان واقعی بیان کنند.

نحوه شناسایی دیپ فیک

با رواج پیدا کردن فناوری دیپ فیک جامعه در مجموع به احتمال زیاد نیاز خواهد داشت تا با مشاهده ویدیوهای دیپ فیک به همان شیوهای که کاربران آنلاین اکنون با شناسایی انواع دیگر اخبار جعلی هماهنگ شدهاند، سازگار شوند. معمولا، همانطور که این درمورد امنیت سایبری صدق میکند، برای شناسایی و جلوگیری از گسترش دیپ فیک هم باید فناوریهای جعلی عمیقتری پدیدار شوند، که این به نوبه خود میتواند چرخه معیوب را ایجاد کند و به طور بالقوه آسیب بیشتری ایجاد کند.

تعداد انگشت شماری اندیکاتور وجود دارد که دیپ فیک را شناسایی می کند:

دیپ فیک های کنونی در متحرک سازی واقع گرایانه چهره ها دچار مشکل هستند و نتیجه ویدئویی است که در آن سوژه هرگز پلک نمی زند، یا به دفعات زیاد یا غیرطبیعی پلک نمی زند. با این حال، پس از اینکه محققان دانشگاه آلبانی مطالعهای را برای تشخیص ناهنجاری چشمک زدن منتشر کردند، دیپ فیکهای جدیدی منتشر شدند که دیگر این مشکل را نداشتند. به دنبال مشکلاتی در پوست یا مو یا چهره ها باشید که نسبت به محیطی که در آن قرار گرفته اید محو تر به نظر می رسند. فوکوس ممکن است به طور غیر طبیعی شفاف به نظر برسد.

آیا نورپردازی در دیپ فیک غیر طبیعی به نظر می رسد؟ اغلب، الگوریتمهای دیپفیک نور کلیپهایی که بهعنوان مدلهایی برای ویدیوی جعلی استفاده می کنند را حفظ میکنند، که با نورپردازی ویدیوی مورد نظر مطابقت ضعیفی دارد. صدا ممکن است با فرد مطابقت نداشته باشد، به خصوص اگر ویدیو جعلی باشد یا صدای اصلی به دقت دستکاری نشده باشد.

مقابله با فناوری دیپ فیک (تشخیص دیپ فیک)

در حالی که دیپ فیک ها با گذشت زمان و با پیشرفت تکنیک ها واقعی تر می شوند، اما در هنگام مبارزه با آنها کاملاً بی دفاع نیستیم. تعدادی از شرکت ها در حال توسعه روش هایی برای شناسایی دیپ فیک ارائه کرده اند که تعدادی از آنها استارت آپ هستند. به عنوان مثال، Sensity یک پلتفرم تشخیص شبیه به آنتی ویروس برای دیپ فیک ها ایجاد کرده است که هنگام تماشای چیزی که مشخص است از طریق رسانه های هوش مصنوعی تولید شده است، از طریق ایمیل به کاربران هشدار می دهد. Sensity از همان فرآیندهای یادگیری عمیق استفاده می کند که برای ایجاد ویدیوهای جعلی استفاده می شود.

عملیات Minerva رویکرد ساده تری برای شناسایی دیپ فیک دارد. الگوریتم این شرکت، دیپ فیکهای احتمالی را با ویدیوهای شناختهشدهای که قبلاً «اثر انگشت دیجیتالی» داشته اند، مقایسه میکند. برای مثال، میتواند نمونههایی از فیلم های مستهجن انتقامجویانه را با تشخیص اینکه، این ویدیو نسخه اصلاح شده ویدئوی موجود توسط دیپ فیک است و قبلا توسط Operation Minerva فهرستبندی شده است، آنها را شناسایی کند.

مقالات مرتبط:

نحوه اجرای برنامه های اندروید در ویندوز 11 بدون شبیه ساز

بهترین گجت هوشمند خانگی در جهان

دیدگاه ها